-

ソリューション

すべてのソリューションを見る

- 製品

- リソース

-

サポート

サポート

さまざまな方法で、販売、製品、技術的な問題などのサポートに対応いたします。

すべてのソリューションを見る

さまざまな方法で、販売、製品、技術的な問題などのサポートに対応いたします。

アップデート : 2022/06/13 07:05:31

キーポイント

2022年5月5日、台北(台湾 — サーバーシステム、サーバーマザーボード、ワークステーションの大手IT企業であるASUSは5日、昨年12月にMLCommons Associationに参加して以来、初めてその結果を発表しました。数十のベンチマークタスクでまたたく間にパフォーマンスの新記録を樹立しました。

具体的には、MLPerf Inference 2.0の最新ラウンドにおいて、ASUSサーバーはデータセンター・クローズド部門で、6つのAIベンチマークタスクにおいて26件の記録を打ち立て、同じGPU構成の他のすべてのサーバーをしのぎました。結果の内訳は、80GBのNVIDIA® A100 Tensor Core GPUを8基搭載したASUS ESC8000A-E11サーバーが12件、24GBのNVIDIA A30 Tensor Core GPUを4基搭載したASUS ESC4000A-E11サーバーが14件でした。

これらの画期的な結果は、AI分野におけるASUSサーバーのパフォーマンスの優位性を明確に示しています。これにより、AIを導入しようとする組織に大きな価値をもたらし、データセンターで最適なパフォーマンスを確保します。

このMLPerf Inference 2.0ベンチマークは、画像分類(ResNet50)、物体検出(SSD-ResNet34)、医療画像分割(3D-Unet)、音声認識(RNN-T)、自然言語処理(BERT)、推奨(DLRM)という6つの一般的なAI推論ワークロードを対象としています。

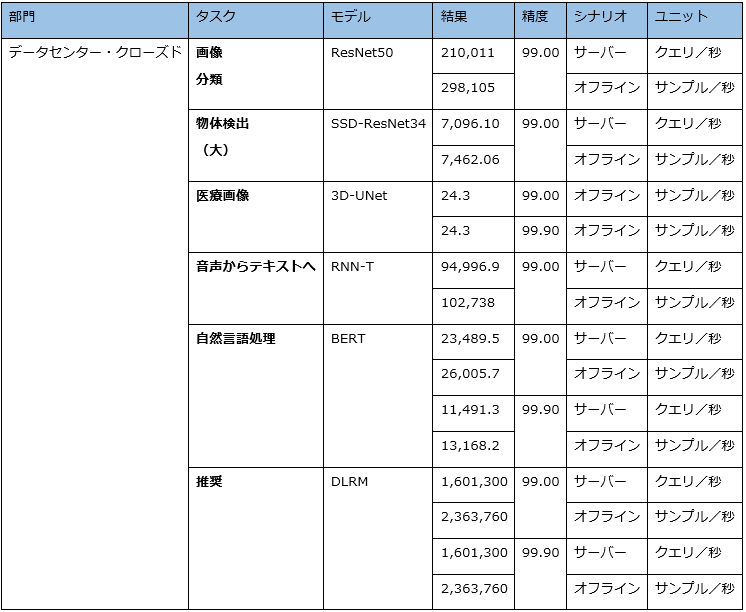

ESC8000A-E11は、以下のようなパフォーマンスで多数の首位を獲得しました。

- ResNet50で1秒間に298,105枚の画像分類を処理

- SSD-ResNet34で1秒間に7,462.06 個の物体認識を完了

- 3D-UNetで1秒間に24.3枚の医療画像を処理

- BERTで1秒間に26,005.7件のQ&Aに対応

- DLRMで1秒間に2,363,760回のクリック予測を完了

ESC8000A-E11の結果表

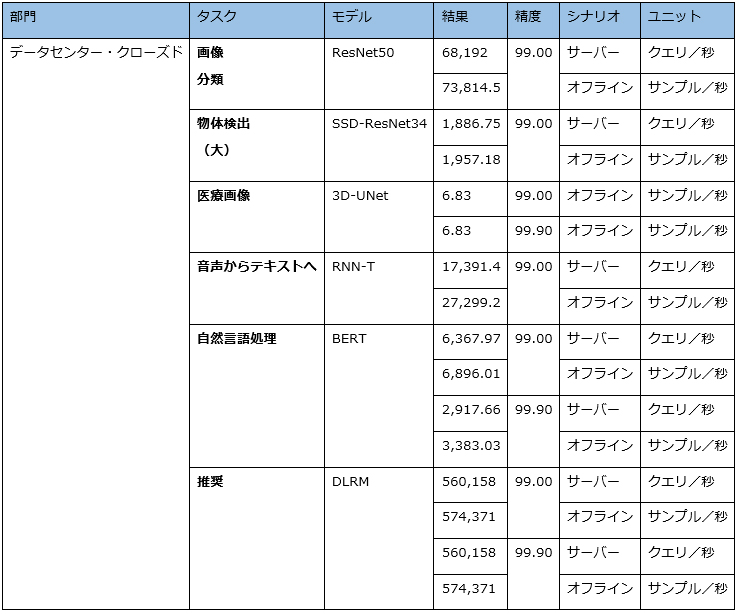

ESC4000A-E11は、以下のようなパフォーマンスで多数の首位を獲得しました。

- ResNet50で1秒間に73,814.5枚の画像分類を処理

- SSD-ResNet34で1秒間に1,957.18枚の物体認識を完了

- 3D-UNetで1秒間に6.83枚の医療画像を処理

- RNNTで1秒間に27,299.2回の音声認識変換を完了

- BERTで1秒間に6,896.01件のQ&Aに対応

- DLRMで1秒間に574,371回のクリック予測を完了

ESC4000A-E11の結果表

12件のMLPerf Inference 2.0記録を達成したNVIDIA認定の4UのESC8000A-E11は、80GBのNVIDIA A100 PCIe Tensor Core GPUを8基とAMD EPYC 7763 CPUを2基搭載しており、AIと機械学習に対する最高の拡張性を実証しています。CPUとGPUのエアフローが独立したトンネルを持つ合理的な熱設計は、空冷式データセンターに高効率な冷却ソリューションを提供します。

NVIDIA認定のESC4000A-E11は、市場で最もコンパクトな2Uフットプリントに格納され、4基の24GB NVIDIA A30 PCIe Tensor Core GPUと2基のAMD EPYC 7763 CPUで構成され、MPLerf Inference 2.0で合計14件の記録を樹立しました。豊富なグラフィックアクセラレーターに加え、NVIDIA NVLink高速GPUインターコネクトをサポートし、AI性能を最大限に引き出します。