專為 AI 推論時代而生

ASUS AI POD 搭載 NVIDIA GB300 NVL72

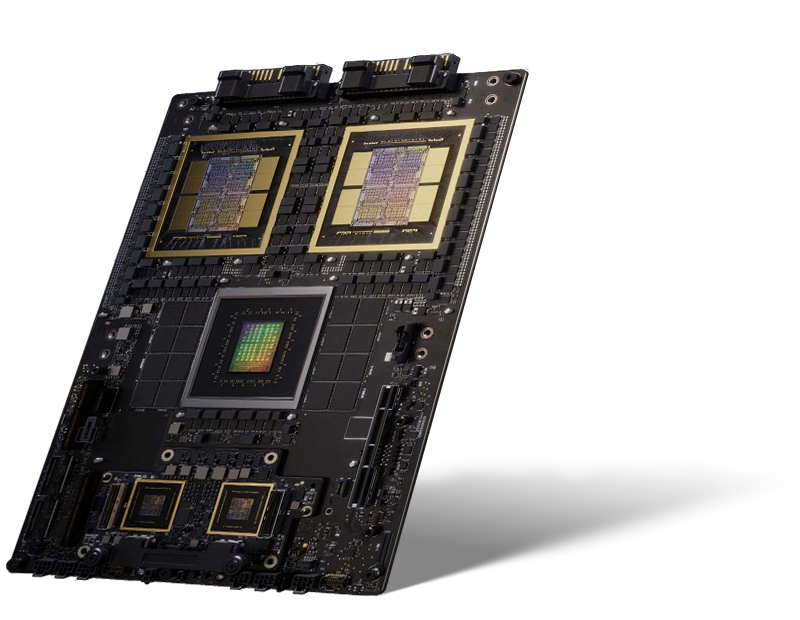

NVIDIA Blackwell Ultra GPU 突破

-

-

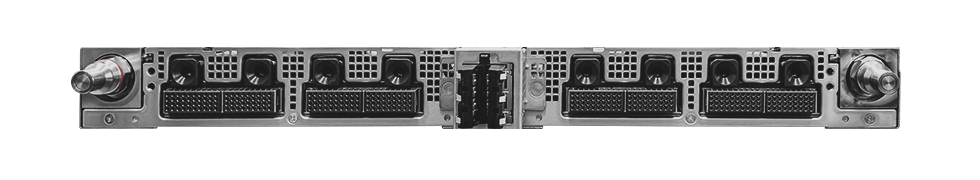

2 x OOB MGMT Switch 1GBe

1 x OS Switch 1GBe (選配)3 或 4 x 1RU Power Shelf 33KW

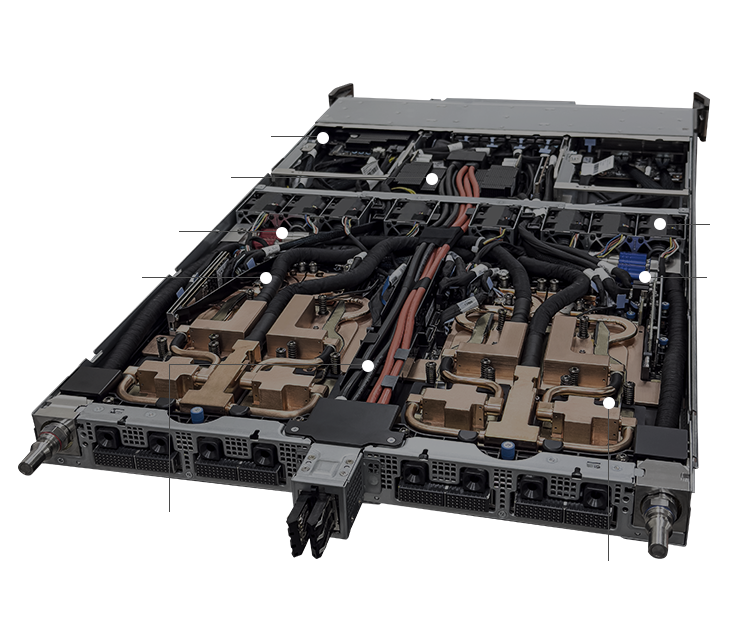

10 x 運算托盤

• 每個托盤 4 個 NVIDIA Blackwell Ultra GPU

• 每個托盤 2 個 NVIDIA Grace GPU9 x NVLink 交換器托盤

• 以 1,800 GB/s 的第五代 NVLink 互連 72 個 GPU8 x 運算托盤

• 每個托盤 4 個 NVIDIA Blackwell Ultra GPU

• 每個托盤 2 個 NVIDIA Grace CPU3 或 4 x 1RU Power Shelf 33KW

-

第五代 NVIDIA NVLink™

NVIDIA Quantum-X800 InfiniBand /

NVIDIA Spectrum-X™ Ethernet

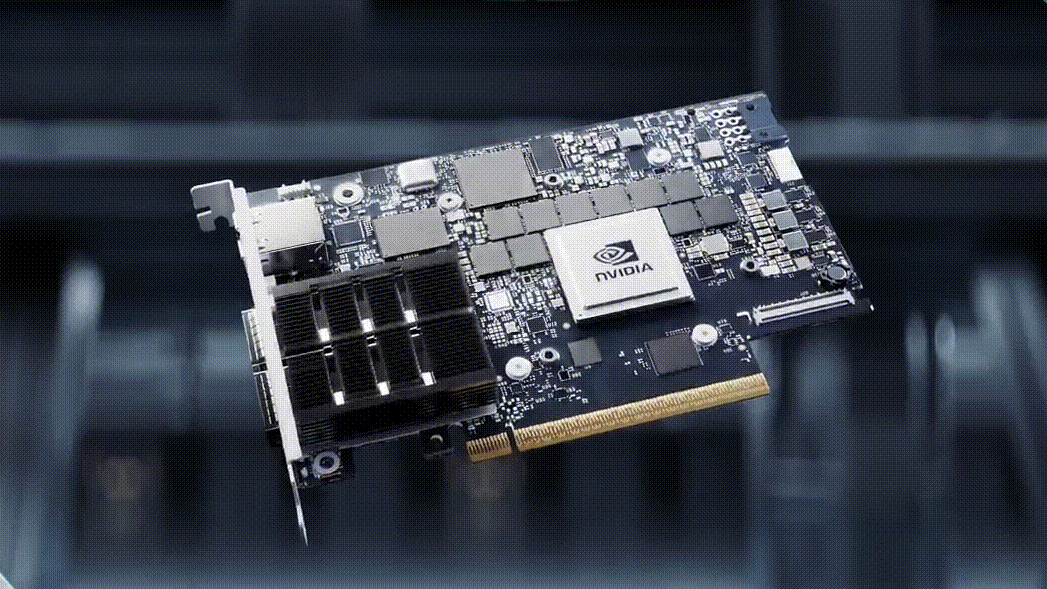

NVIDIA® BlueField®-3

加速上市的完整解決方案

最大化效率,最小化熱量

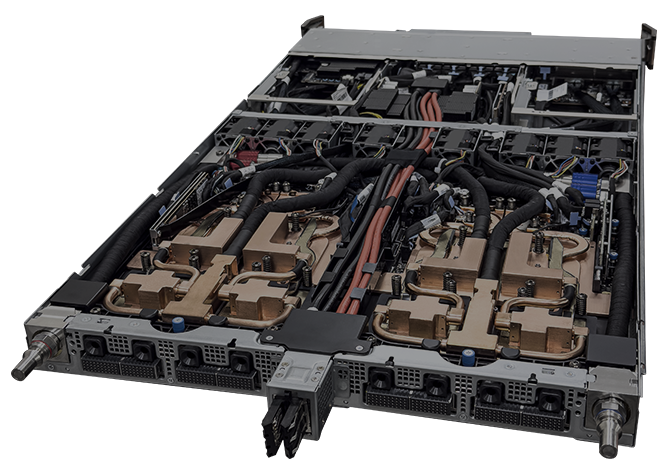

液冷架構

-

液對氣解決方案

適合設施緊湊的小型資料中心。

旨在滿足現有氣冷資料中心的需求,並可輕鬆與當前基礎架構整合。

非常適合尋求立即實施和部署的企業。 -

液對液解決方案

適合具有高工作負載的大規模、廣泛基礎架構。

提供長期的低 PUE,並隨著時間推移維持能源效率。

降低總體擁有成本 (TCO),實現最大價值和符合成本效益的營運。

經驗證的拓撲

適用於可擴充的 AI 基礎架構

-

可預測的效能

為要求嚴苛的 AI 工作負載確保頻寬和低延遲

-

簡化的擴充

經驗證的設計確保從機櫃到叢集的順暢擴展

-

部署效率

參考架構可加速設定並降低複雜性

加速您的上市時間

華碩自有軟體與控制器

-

ASUS Control Center (ACC)

用於監控和控制華碩伺服器的集中式 IT 管理軟體

- Power Master – 資料中心的有效能源控制

- 輕鬆搜尋和控制您的裝置

- 輕鬆快速地增強資訊安全

-

什麼是 ASUS AI POD 搭載 NVIDIA GB300 NVL72?什麼是 ASUS AI POD 搭載 NVIDIA GB300 NVL72? ASUS AI POD 搭載 NVIDIA GB300 NVL72 是一款機櫃級 AI 基礎架構解決方案,整合了 72 個 NVIDIA Blackwell Ultra GPU 和 36 個 NVIDIA Grace CPU,可為大規模 LLM 推論、訓練和 AI 推論提供強大動力。

-

ASUS AI POD 中的 NVIDIA GB300 NVL72 如何提升 AI 效能?ASUS AI POD 中的 NVIDIA GB300 NVL72 如何提升 AI 效能? NVIDIA GB300 NVL72 利用第五代 NVIDIA NVLink™ 和搭載 Quantum-X800 InfiniBand 或 Spectrum-X™ 乙太網路的 ConnectX-8 SuperNIC,提供無縫的 GPU 通訊、低延遲和高頻寬的資料流,從而加速訓練和推論。

-

ASUS AI POD 搭載 NVIDIA GB300 NVL72 有哪些散熱選項?ASUS AI POD 搭載 NVIDIA GB300 NVL72 有哪些散熱選項? ASUS AI POD 搭載 NVIDIA GB300 NVL72 支援液對氣和液對液散熱解決方案,確保在最繁重的 AI 工作負載下也能有效散熱並維持穩定效能。

-

ASUS AI POD 搭載 NVIDIA GB300 NVL72 是為資料中心和企業 AI 設計的嗎?ASUS AI POD 搭載 NVIDIA GB300 NVL72 是為資料中心和企業 AI 設計的嗎? 是的。以 NVIDIA GB300 NVL72 為基礎的 ASUS AI POD 專為企業 AI、超大規模資料中心、雲端服務供應商和研究機構進行最佳化,為兆級參數 LLM、MoE 和其他要求嚴苛的 AI 應用提供可擴充的效能。

-

ASUS AI POD 搭載 NVIDIA GB300 NVL72 包含哪些服務?ASUS AI POD 搭載 NVIDIA GB300 NVL72 包含哪些服務? 除了硬體之外,華碩專業服務還包括軟體整合、儲存解決方案、網路拓撲設計、散熱專業知識和部署服務,協助組織加速上市時間。